Lemme Google that for you: discriminerende algoritmes

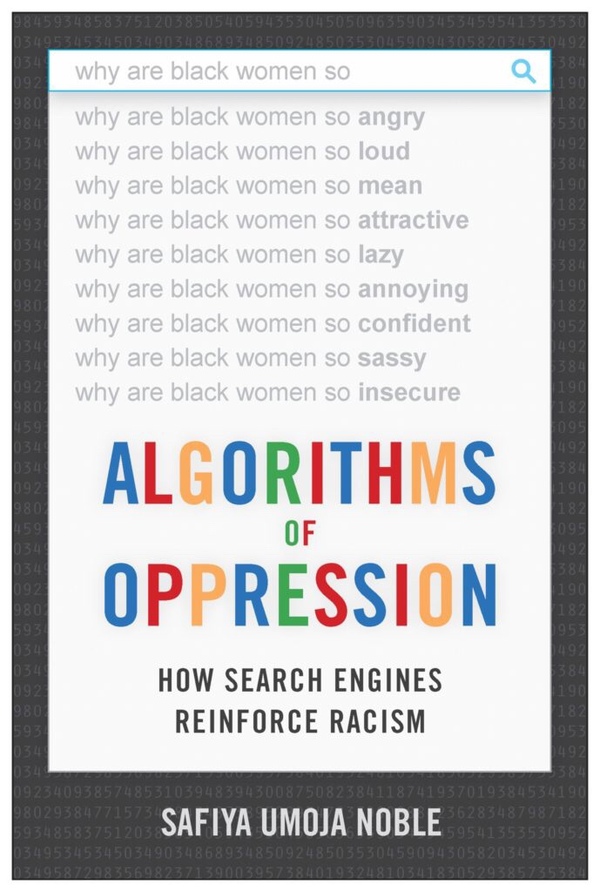

Door Sakina Elkayouhi, op Mon Jan 20 2020 23:00:00 GMT+0000Wie heeft het ooit niet gedaan: die nieuwe crush of je potentiële werkgever googelen? Of we Google nu gebruiken voor de kleinste futuliteiten of de grootste levensvragen, in minder dan een seconde krijgen we alle antwoorden. En kinderlijk groot is ons vertrouwen in hun objectieve ranking. Een grote misvatting, zo stelt Safiya Umoja Noble in haar boek Algorithms of Oppression. Werkt het internet discriminatie in de hand?

Noble begon in 2010 onraad te ruiken toen ze op Google toevallig ‘black girls’ had ingetypt om haar nichtjes een middagje te entertainen. De Afro-Amerikaanse mediaprofessor schrok van de grote hoeveelheid porno waarop ze stootte. Waarom stonden net deze resultaten bovenaan? Was dit nu het meest representatieve beeld van zwarte meisjes?

Eenzelfde patroon zag Noble ook terugkomen bij de representatie van andere vrouwen van kleur en gemarginaliseerde groepen, zoals seksuele minderheden en jongeren met biculturele achtergrond. In Algorithms of Oppression: How Search Engines Reinforce Racism (2018) is ze op zoek gegaan naar welke systemen daarachter zitten.

'Sommige ontwikkelaars van zoekalgoritmes willen openlijk seksistische en racistische attitudes promoten.'

Veel is natuurlijk gelegen aan de algoritmes die onze dagelijkse cultuur bepalen. Wanneer je een video bekijkt op YouTube, een nieuwe serie getipt krijgt door Netflix of een transactie doet bij de bank: steeds zijn achter de schermen diezelfde sets van voorgeprogrammeerde regels en instructies aan het werk.

Efficiënt regelen ze het verkeer tussen jouw input en de output van het systeem, maar soms kunnen ze de plank ook volledig misslaan. Als voorgeprogrammeerde formules houden algoritmes nu eenmaal geen rekening met de context. Net daarom roepen ze al langer ethische vragen op rond privacy en neutraliteit. Die discriminerende zoekresultaten die Noble aantrof, versterken die scepsis alleen maar. Waren zij louter toeval?

Hoewel Google zijn algoritmes inmiddels heeft aangepast, blijft de techgigant volgens Noble racistische en seksistische ideeën in de samenleving in stand houden. Deels gebeurt dat min of meer onbewust, als gevolg van vooroordelen bij de ontwikkelaars of de gebrekkige inclusie in hun teams.

Tegelijk ziet Noble ook bewuste manipulatie van algoritmes. ‘Sommige ontwikkelaars van zoekalgoritmes willen openlijk seksistische en racistische attitudes promoten, terwijl wij veronderstellen dat diezelfde werknemers “neutrale” en “objectieve” selectietools ontwikkelen.’

Waar op het internet een service gratis is, is de kans groot dat jijzelf het product bent.

Ook zorgt Search Engine Optimalisation (SEO) ervoor dat bepaalde websites bewust bovenaan gehouden worden, ten voordele van Google’s eigen commerciële gewin of dat van zijn adverteerders. Natuurlijk weet Noble ook wel dat Google geen instituut voor gratis onderzoek is, maar wel een commerciële speler in de business van informatie-optimalisatie. En waar op het internet een service gratis is, is de kans groot dat jijzelf het product bent.

Dat er zo geld verdiend kan worden met allerlei discriminerende denkbeelden, maakt van het idee van een democratisch en pluriform internet slechts een illusie, zo besluit de media-onderzoekster. Daarmee snijdt Algorithms of Oppression een interessante discussie aan: de maakbaarheid van een eerlijke, inclusieve informatiesamenleving. Waar te beginnen?

Bonding & bridging

Een sleutel lijken sociale netwerken, aangezien zij fungeren als een dwarsdoorsnede van de samenleving. Het is de plek waar Jan met de pet samenkomt met de geitenwollensokkenparade, de doemdenkers, de cyberimams, cultuurpessimisten, internet warriors, trollen, hipsters, mipstersz, klimaatontkenners, helicopter mums, links, rechts, publieke figuren, influencers en andere instagramsletten.

Online toont zich onze eigentijdse aandachtgeile egocultuur als onder een vergrootglas.

Ziedaar meteen ook het probleem: sociale netwerken bieden een extreem uitvergrote versie van gefragmenteerde identiteiten. Online toont zich onze eigentijdse aandachtgeile egocultuur als onder een vergrootglas. We zijn er meer verbonden dan ooit, maar tegelijk staan we er als samenleving ook veel verder van elkaar af.

Dat komt omdat de algoritmes van sociale media er net op ingesteld zijn om zogenaamde filterbubbels te creëren. Ze versterken onze hypergevoeligheid voor likes en hypes en doen vooral extreme meningen de bovenhand halen.

Zo bleek uit een recent onderzoek van de Nederlandse krant De Volkskrant en het online journalistiek platform De Correspondent hoe YouTube rechtse radicalisering in de hand werkt. Het algoritme dat de aanbevelingen doet voor nieuwe video’s, speelt daar een grote rol in. Op het broadcastplatform krijgen gebruikers vaak filmpjes aanbevolen die net iets extremer zijn dan wat ze zelf hebben opgezocht.

Toch kan YouTube ook werken als een democratisch en pluriform medium. Neem de kracht van het platform om gemarginaliseerde individuen samen te brengen in een collectieve strijd voor zichtbaarheid in het publiek domein (‘bonding’). Tegelijkertijd is het ook de plek waar mensen uit diverse gemeenschappen en met uiteenlopende wereldbeelden elkaar treffen rond een gedeelde interesse zoals een celebrity of een hobby (‘bridging’).

Afro-Amerikaanse jongeren zijn lang niet alleen het passieve slachtoffer van bevoordeelde algoritmes, maar ook early adopters.

Dat onderstreept ook Noble in Algorithms of Oppression voor Afro-Amerikaanse jongeren: ze zijn lang niet alleen het passieve slachtoffer van bevoordeelde algoritmes, maar ook early adopters die elkaar online opzoeken, content creëren en hun verhalen delen om samen hun stem te laten horen.

Koekjes van eigen deeg

Zo deed ik drie jaar geleden voor mijn masterscriptie een onderzoek naar de rol van bekende diverse YouTubers binnen het debat over een inclusievere media-industrie. Wat al die jongeren gemeen hadden, was hun diverse achtergrond en hun kijk op YouTube als een manier om hun ‘een eigen ding te doen’. Ofwel ging het hen om een passie of hobby die ze met een breder publiek wilden delen, ofwel hadden ze een eigen kanaal geopend uit ergernis over de mainstream media, waardoor ze zich niet aangesproken voelden.

Via trial-and-error leerden deze jongeren om als mediamaker een publiek op te bouwen en je content ook buiten YouTube zichtbaar te maken. Tegelijk gingen ze beseffen dat talent en populariteit ook niet alles zijn. Net als in de tv-industrie gelden ook online (onuitgesproken) spelregels die iemand kunnen kraken of maken, waaronder precies die bevooroordeelde algoritmes.

Maar door ervaringen uit te wisselen ontwikkelden ze ‘trucjes’ om hun werk het beste te verspreiden. Ze leerden het systeem manipuleren door in te spelen op populaire onderwerpen, elkaars content te delen of bepaalde keywords te gebruiken. Door die actieve vorm van online cultuurparticipatie lijken deze jongeren zelfs meer digitaal geletterd dan hun witte leeftijdsgenoten. Al doende leerden ze het systeem te ontcijferen dat hen zou kunnen discrimineren, en als het ware met koekjes van eigen deeg terug te vechten.

We dragen een collectieve verantwoordelijkheid voor meer onbevooroordeelde algoritmes.

Dat wil natuurlijk niet zeggen dat we bevooroordeelde algoritmes zoals geschetst door Noble, moeten bagatelliseren. Sterker nog, omdat de virtuele en reële wereld tegenwoordig zo sterk in elkaar overvloeien, beperken ze zich zeker niet alleen tot de online cultuur. Ze zijn deel van één tijdgeest.

Daarom denk ik dat oplossingen gezocht moeten worden in een multidisciplinaire aanpak. In tijden waarin online de grenzen tussen maker, consument en distributeur vervaagd zijn, is een mentaliteitswijziging nodig. Het is daarom niet ‘zij de media’, maar ‘wij de media’. We dragen een collectieve verantwoordelijkheid voor meer onbevooroordeelde algoritmes.

Eerlijke algoritmes?

Concrete aanbevelingen geeft Sennay Ghebreab, een Nederlandse neuro-informaticus en hoogleraar aan de Universiteit van Amsterdam, in een interview met het Nederlandse (online) magazine OneWorld. Als data representatief moeten worden voor álle bevolkingsgroepen, zegt hij, hebben we allereerst nieuwe formules nodig hebben.

En daarvoor moeten alle vooroordelen in historische data opgespoord en gecorrigeerd worden. Tegelijk benadrukt Ghebreab dat ook alle verantwoordelijken voor die formules (makers, gebruikers én toezichthouders) in alle opzichten divers horen te zijn qua kleur, gender en achtergrond.

Algoritmes zijn de toekomst, maar innovatie zonder inclusie en transparantie werkt uitbuiting in de hand.

Om iederéén meer inzicht te bieden in de werking van algoritmes en artificiële intelligentie, heeft vooral het onderwijs een belangrijke rol te spelen. Daarom ben ik verheugd dat in Nederland eindelijk stappen genomen worden om digitale geletterdheid en burgerschap als verplichte leervakken op te nemen in het basis- en voortgezet onderwijs. Maar ook bottom-up initiatieven zijn belangrijk. Terwijl het nu meestal overheidsinstanties zijn die data verzamelen, zijn dringend meer eigen verhalen uit onderbelichte gemeenschappen nodig.

Een goed voorbeeld is het Brusselse initiatief MolenGeek. Dat werd vier jaar geleden door Julie Foulon en Ibrahim Oussari opgestart als een start-up om digitale skills aan te leren bij jongeren uit kansarme gezinnen en moeilijke wijken. Intussen is MolenGeek een volwaardige programmeerschool, bedrijfscentrum én broedmachine voor start-up en nieuw talent.

Ten slotte is het is ook aan de overheid om transparantie, eerlijkheid en betrouwbaarheid van algoritmes te waarborgen. Want in een wereld vol fake news geldt meer dan ooit dat correcte informatie macht is. Dat vereist dat we veel beter gaan waken over de blinde vlekken in de techniek van sociale netwerken. Want algoritmes zijn de toekomst, maar innovatie zonder inclusie en transparantie werkt uitbuiting in de hand.

Het is daarom belangrijk iedereen mee op de kar te krijgen. Welke input geeft welke uitkomst? Welke normen en waarden brengt dat mee? Wie zit er achter de (programmeer)knoppen, waarom en met welk doel?

We zijn collectief verantwoordelijk om te streven naar correcte informatie. Informatie is immers een publiek goed en brengt zowel rechten als plichten met zich mee, voor ons allemaal. Niet alleen voor de happy few in Silicon Valley.